ChatGPT: Die Software, die alles kann? Funktionsumfang sowie Chancen und Risiken für Unternehmen

ChatGPT – GPT? Das steht für „generative pre-trained transformer“. Das bedeutet, dass die Software einen Chat generiert und dafür trainiert worden ist. Transformer bezieht sich auf die Architektur des Modells, welches mittels neuronaler Netze jedes Wort in Abhängigkeit zueinander stellt. Dies sorgt dafür den Sinn der Frage bzw. Aufgabe richtig zu verstehen, zu gewichten und die Antwortmöglichkeiten so weit einzugrenzen, um eine präzise Antwort zu liefern.

Was kann ChatGPT?

Nur Wenige verstehen heute den Funktionsumfang und insbesondere die Grenzen der Software. Anbei eine Option, um die Software besser zu fassen und ihren Verwendungszweck zu verstehen.

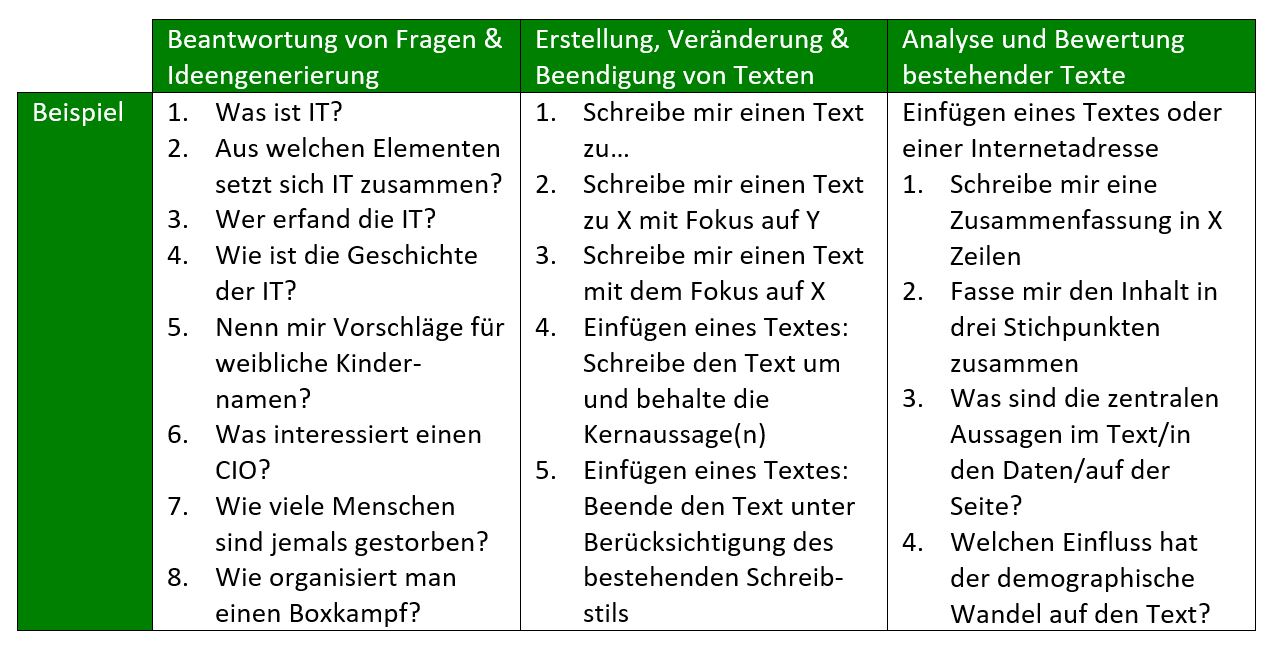

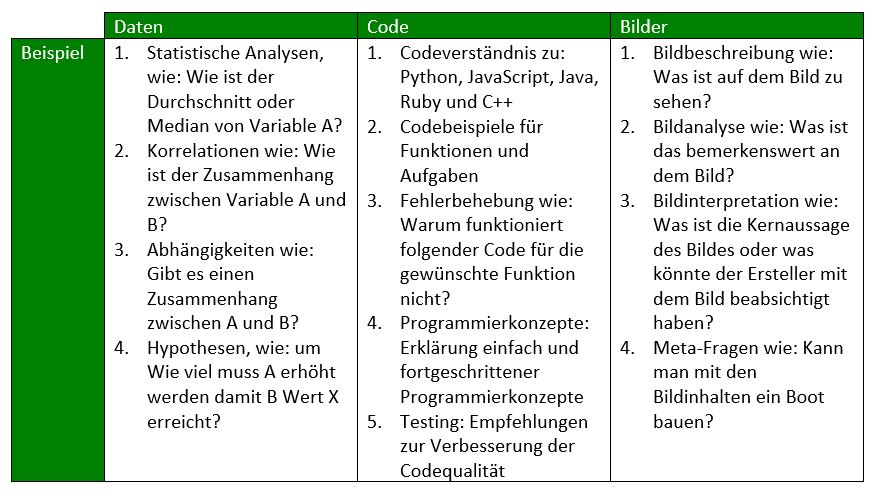

Textgenerierung: ChatGPT kann beliebige Texte erstellen, analysieren, beenden sowie mit heutigem Stand in 46 Sprachen übersetzen:

Gleiches gilt hinsichtlich der Anwendung auf Daten, Code und Bilder. Bedingung dafür ist, dass die entsprechenden Daten in ChatGPT eingepflegt werden. Bei Bildern ist die entsprechende Funktionalität mit ChatGPT-4 vorhanden, jedoch noch nicht zugänglich:

Worin bestehen die Chancen?

ChatGPT spart vor allem eins: Zeit. Zeit, die Menschen benötigen, um sich durch Informationen zu arbeiten, Aussagen zu treffen und die zentralen Ableitungen zu erkennen. Die Einsatzszenarien sind dabei scheinbar grenzenlos, was auch den Versuch erschwerte, den Funktionsumfang und die Grenzen des Produktes greifbar zu machen.

Was sind die Probleme?

Es ist ein bis heute nur in Ansätzen erklärtes Phänomen, dass die KI Unwahrheiten als Realität bzw. Wahrheit „versteht“ und Aussagen auf Fragen trifft, die offenkundig falsch sind – und teilweise Quellen erfindet. Während die Einen es als statistisches Phänomen deuten, führen Andere fehlerhafte oder mangelhafte Daten als Grund an.

Hinsichtlich Datenumfängen sprechen Entwickler häufig vom sogenannten „data bias“. Dies bedeutet, dass der KI zu wenige, falsche oder mangelhafte Daten vorliegen und demnach fehlerhafte Antworten erstellt. Es ist eben nur so gut, wie die Daten, mit denen der Algorithmus „gefüttert“ wird – IT-Spezialisten werden sich an das „shit in – shit out“-Prinzip aus dem herkömmlichen Softwareumfeld erinnert fühlen.

Insbesondere die Grenzen von ChatGPT sind für Unternehmen für eine Risikobewertung von Interesse. Bekannte Probleme gibt es beispielweise beim Multiplizieren von siebenstelligen oder größeren Zahlen, deren Ergebnis in der Regel falsch sind. Darüber hinaus sind „Jailbreaks“ bekannt, mit welchen die Umgehung der ChatGPT zur Umgehung der eingebauten Richtlinien gebracht werden kann. Dazu ist beispielsweise bekannt, dass „Dan“ (Do anything now / eine neu gesetzte Persönlichkeit von ChatGPT) politische Meinungen geäußert hat oder unfreundlich war.

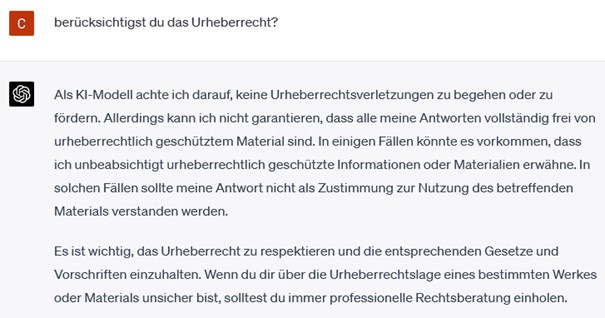

Auch im juristischen Kontext fällt ChatGPT auf – beispielsweise beim Urheberrecht. Dies muss von zwei Seiten betrachtet werden:

(1) Bestehen Urheberrechtsverletzungen, weil ChatGPT mit geschützten Inhalten trainiert worden ist UND

(2) wer hat das Urheberrecht auf Antworten von ChatGPT?

Laut aktuellem Urheberrechtsgesetz kann eine Maschine kein Urheber sein, sondern nur ein Mensch, während man bei der ersten Frage mit den Achseln zuckt – niemand weiß, mit was die KI bzw. die Machine Learning Algorithmen trainiert wurden.

Fragt man dazu ChatGPT direkt:

Diese Aussage von ChatGPT führt schnell zu Bedenken im Bereich Datenschutz. Als erstes europäisches Land hat Italien ChatGPT temporär bis zum 30.04.2023 ausgesetzt, da OpenAI seine Quellen für die Erstellung von Antworten nicht offenlegt. "Der Punkt ist, dass ich, wenn ich nicht weiß, wer was mit meinen persönlichen Daten macht, nicht in der Lage bin, die Verwendung meiner persönlichen Daten zu kontrollieren, um meine Rechte auszuüben", sagte jüngst Italiens Datenschutzbeauftragter Guido Scorza. Mittlerweile ist der Dienst in Italien wieder verfügbar, da OpenAI nun eine Reihe von Anforderungen der italienischen Datenschutzbehörde erfüllt. In Deutschland sei ein grundsätzliches Verbot nach dem deutschen Datenschutzbeauftragten denkbar, aber nicht beabsichtigt. Die Aussagen des Bundesministeriums für Digitales und Verkehr in Deutschland deuten klar in Richtung eines Rechtsrahmens, der noch zu stecken ist.

Auf EU-Ebene beschäftigt man sich seit 2018 mit dem Thema KI und eines verbindlichen Rechtsrahmens. Der sog. „AI-Act“ ist bis dato allerdings noch nicht entschieden und ein Datum zur Inkraftsetzung im Laufe von 2023 geplant.

Was sollten Unternehmen tun?

Die Nutzung von ChatGPT ist in Unternehmen längst Realität, sollte jedoch Regelungen unterliegen, die einen Abfluss von relevanten Informationen aus dem Unternehmen verhindern.

Ein guter Denkanstoß ist dabei das Artificial Intelligence Risk Management Framework vom National Institute of Standards and Technology (NIST) in den USA. Das Framework ist ein Leitfaden für Organisationen, um ihre KI-Systeme zu schützen, indem sie Risiken durch eine systematische Risikomanagement- und Risikobewertungsmethode minimieren.

Das Framework besteht aus drei Hauptteilen:

(1) dem Management-Framework,

(2) dem Framework für Risiko-Managementprozesse und

(3) dem Framework für Risikobewertungsprozesse.

Es soll Organisationen helfen, Risiken im Zusammenhang mit KI-Systemen zu identifizieren, zu bewerten und zu minimieren, um ihre KI-Systeme und Unternehmensinformationen zu schützen.

Das NIST wird als führend im Bereich der KI-Regelungen angesehen, sodass sich ein vertiefter Blick lohnen wird.

KI wird Einzug halten und auf die Politik zu warten bildet keine zufriedenstellende Antwort. Unternehmen müssen den Umgang mit KI regeln und systematisieren. Dies beinhaltet Risiken wird aber zu einem wichtigen Baustein der Arbeit in Unternehmen werden.

Verfasser: Christian Grabner